Estados Unidos y la Unión Europea consideran que sus prioridades son la propiedad intelectual y la privacidad de los usuarios.

Desde la llegada de la inteligencia artificial hace algunos años, pero popularizada hace poco de la mano de OpenAI con ChatGPT y otros modelos generativos como Midjourney, Stable Diffusion y DALL-E2, la respuesta de los gobiernos de diferentes partes del mundo fue intentar controlar esta tecnología para evitar un uso malintencionado o abusivo.

Debido a que cada continente tiene una visión diferente del “problema” que genera la IA, las formas de abordar su regulación son diferentes.

Según Percy Diez Quiñones, docente y coordinador del Observatorio Tecnológico de la Universidad de Lima, actualmente existen tres tendencias en el mundo.

“Mientras que en Estados Unidos la preocupación está relacionada a temas de patentes y propiedad intelectual, en la Unión Europea se han concentrado especialmente en ciberseguridad y privacidad de la información. En Latinoamérica parece haber una tendencia más cercana al uso ético de esta tecnología”, afirmó Diez en una entrevista exclusiva con Infobae.

Qué es el uso ético de la inteligencia artificial

Para la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO), la inteligencia artificial no debería ser una zona sin ley pues su influencia puede impactar directamente en las vidas de las personas.

Aunque en el año 2021, los países miembros de la UNESCO adoptaron las recomendaciones de la organización con respecto al uso ético de la IA, estas no son vinculantes y por lo tanto no representan un compromiso real.

Es a raíz de la llegada de modelos generativos más avanzados que se está dando más importancia a su regulación.

Un pronunciamiento emitido el 30 de mayo del año 2023, por Audrey Azoulay, directora general de la organización, se indicó que “el mundo necesita normas éticas más estrictas para la inteligencia artificial”. Básicamente esto se trata de asegurarse de que esta tecnología sea utilizada para el bien común de la humanidad y en los intereses de los ciudadanos.

¿Pero cómo es que los diferentes países de Latinoamérica están intentando implementar estas nuevas leyes regulatorias y qué ideas tienen en común quienes las proponen? Infobae pudo conversar en exclusiva con expertos y legisladores quienes están detrás de estas iniciativas

Perú

La iniciativa de ley se presentó oficialmente el 22 de agosto del año 2022 por el congresista José Cueto, pero no fue hasta el 30 de mayo del año 2023 que fue aprobada por el Congreso de la República. Infobae contactó con el legislador, quien dio algunas opiniones sobre su proyecto.

En principio, el documento llamado “Ley que promueve el uso de la inteligencia artificial en favor del desarrollo económico y social del país” surgió porque para ese entonces Cueto ya consideraba que los avances hechos en este campo eran alarmantes y requería de un marco legal pues indicó que “el avance de esta tecnología podría traer problemas al desarrollo humano”.

Para el congresista, que tanto en su documento como durante la entrevista con Infobae evita mencionar la palabra “regulación”, la tecnología relacionada con la IA “no se puede controlar, pero sí se puede supervisar, evaluar y apoyar su desarrollo”. Es por eso que todo el contenido del proyecto se basa en el uso que las personas les dan a estas herramientas más que en gestionar reglas específicas para las plataformas y las empresas que las producen (de esto se encargará el Poder Ejecutivo).

El proyecto de ley sí habla sobre que es necesario que estas herramientas deben “privilegiar a la persona y el respeto de los derechos humanos con el fin de fomentar el desarrollo económico y social del país” por medio de valores como la transparencia, la sostenibilidad y la garantía de un uso ético.

“(La ley) no está orientada únicamente al control, sino a poder evaluar los riesgos que esto conlleva y en base a ello tomar decisiones”, aseguró Cueto.

Con la norma aprobada por el Congreso de la República, el gobierno peruano tiene 90 días para crear un reglamento para esta nueva ley, que luego pasaría a ser implementada. Cueto indicó que espera que esto pueda realizarse antes de diciembre del año 2023.

Colombia

El caso de Colombia es distinto pues aún cuando tiene cierta comprensión sobre los riesgos del uso de la inteligencia artificial, los verdaderos procesos regulatorios no son generados en su territorio.

En ese sentido, el senador, David Luna indicó en exclusiva para Infobae que el país “ha empezado a tener interés en la materia, pero de forma muy abstracta y arrastrada por tendencias internacionales”.

El senador David Luna, ex Ministro de Tecnologías de Información y Comunicaciones, considera que en Colombia las

iniciativas de regulación de las IA están influenciadas por tendencias internacionales. (Colprensa/Sofía Toscano)

En el documento 4023 generado por el Consejo Nacional de Política Económica y Social en el año 2019 se establece que Colombia adoptaría lineamientos de la Organización para la Cooperación y Desarrollo Económico (OCDE) sobre políticas de desarrollo de la inteligencia artificial y que se requería del establecimiento de un marco ético para implementarlas.

Fue recién en el año 2022, cuando se creó la Misión de Expertos de Inteligencia Artificial para crear políticas educativas y de empleo con el uso de esta tecnología. Ese mismo año también adoptó las recomendaciones de ética en Inteligencia Artificial de la UNESCO.

En el año 2023 ya se ha intentado investigar si ChatGPT cumple con normas de protección de datos personales que están especificadas en otras leyes que ya existían desde el año 2012.

Según Luna, los legisladores de este país aún no entienden cómo abordar esta discusión y, al igual que Cueto, considera que “se necesitan parámetros de protección de datos y uso ético de la IA, pero no frenar el desarrollo de nuevas tecnologías”.

“Se deben implementar manuales éticos que ya existen para el desarrollo de esta tecnología (…) y desarrollar políticas que busquen neutralizar las consecuencias negativas de la IA”, aseguró a Infobae. Sin embargo, también hizo énfasis en que la sobrerregulación puede quitarle fuerza a la creación de estas herramientas.

Llama mucho la atención que tanto en Perú y en Colombia, los legisladores consideren que la emisión de normas regulatorias de este tipo de tecnologías es una forma de frenar el desarrollo o de desalentar la creación de estas herramientas digitales, mientras que en Estados Unidos y Europa se considera que la privacidad de los ciudadanos es la prioridad.

Quizás una de las explicaciones para esta interpretación de la regulación la pueda indicar Oscar Montezuma, representante de Niubox Legal, una consultora de asuntos regulatorios presente en Colombia, Ecuador y Perú.

En su conversación exclusiva con Infobae, indicó que Latinoamérica es una región caracterizada principalmente como una consumidora de tecnología más que productora de la misma, por lo que regular una tecnología nueva podría ser considerado como una oportunidad perdida para mejorar su desarrollo económico.

También, hizo referencia a que algunas personas pueden caer rápidamente en lo que él llama “tecno-pánico”: el terror a que las películas de ciencia ficción como Terminator se hagan realidad y esta tecnología termine dominando al planeta.

Al igual que Luna, Montezuma aseguró que la mejor solución sería que se adopten, como en Colombia, las mejores prácticas con respecto al desarrollo de la inteligencia artificial en lugar de limitar su creación con obstáculos legales.

Otros casos de regulación

En México, el diputado Ignacio Loyola presentó durante el año 2023 una iniciativa para expedir la “Ley para la regulación ética de la inteligencia artificial y la robótica” en la que nuevamente se menciona que todo su desarrollo debe estar orientado a fines que beneficien a los ciudadanos. Sin embargo, también sugiere la creación de un Consejo formado por “ciudadanos con probidad ética y conocimiento sobre IA y robótica”.

En el caso de Argentina, la propuesta no pasa por crear una ley nueva para la inteligencia artificial, sino modificar una existente para “regular el funcionamiento ético de los sistemas”. Bajo este principio, a diferencia del resto de ejemplos, se indica que se deben “detener los avances cuando se considera que se vulneran principios y valores éticos dispuestos”.

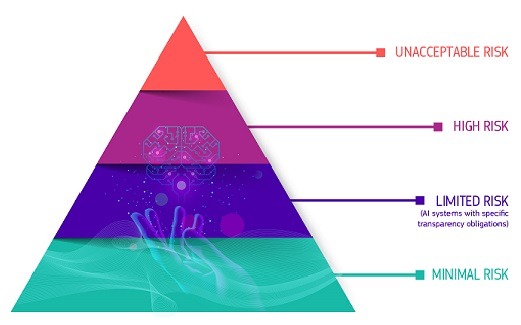

Chile también presentó una norma relacionada con el uso ético de la inteligencia artificial para “asegurar la protección de los derechos fundamentales”. Sin embargo, la diferencia es que su enfoque es mucho más cercano al método europeo: se califican los riesgos de cada modelo de IA (inaceptable y alto) y además cada proveedor deberá pedir permiso a una Comisión para operar en el territorio.

El igual que en Europa, Chile propone una regulación de la inteligencia artificial basada

en los riesgos potenciales de esos programas. (Comisión Europea)

Tanto Diez, Cueto, Luna y Montezuma, quienes hablaron con Infobae, coinciden en una cosa en particular relacionada con el tratamiento de esta regulación: los intentos deben ser cuidadosos para asegurar que la tecnología siga estando disponible y no retrasar el desarrollo de los países de la región.

Lo cierto es que la tendencia de ajustar un marco legal para el “uso ético” de la inteligencia artificial tiene diferentes formas de aplicarse dependiendo de las necesidades de cada país. Sin embargo, también deben establecerse mecanismos para intentar que las normas avancen casi tan rápido como lo hace la tecnología o de lo contrario se tendrá leyes obsoletas para tecnología que evoluciona cada vez más rápido.

Fuente: Infobae